Olá, Comunidade Pipefy,

Temos uma ótima notícia: agora, você pode integrar o Pipefy com sua ferramenta de relatórios, como PowerBI ou DataStudio, por meio de API! Veja como:

Com Relatórios, você pode filtrar dados dos seus processos em tempo real, organizá-los em colunas e exportá-los em formato de uma planilha de Excel para analisar as informações que deseja.

Se sua equipe precisa exportar relatórios com frequência e em um determinado período de tempo, você pode automatizar esse processo!

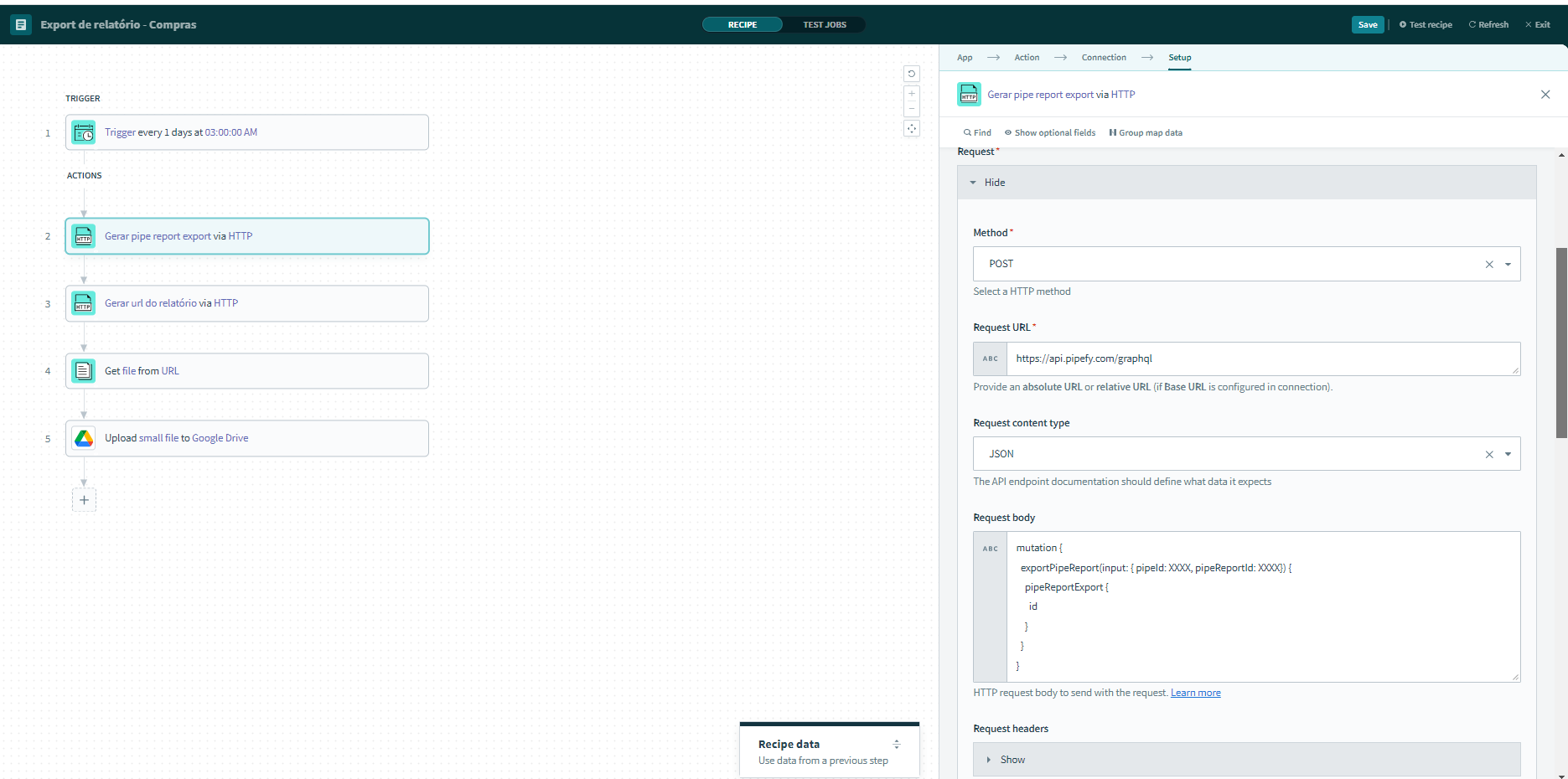

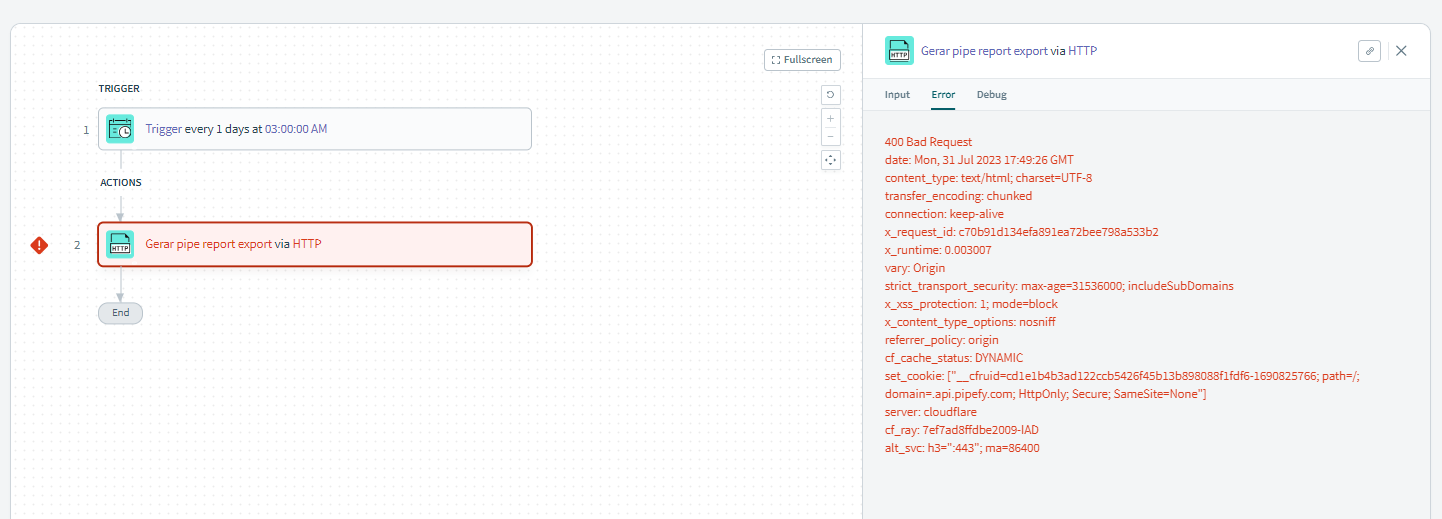

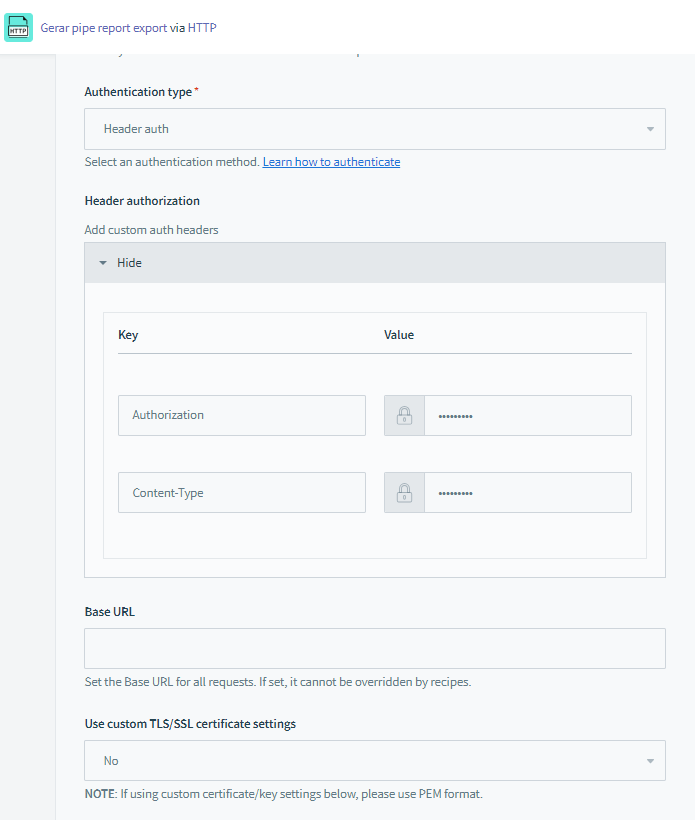

Configure uma rotina de API Scheduler para automatizar a extração do relatório utilizando uma mutation. O relatório será exportado no período de tempo que você determinar no seu scheduler.

Para fazer a extração do relatório são necessárias duas chamadas, a primeira é uma mutation que obterá na resposta um ID para ser utilizado na extração, e a segunda, é uma query, que utilizará a resposta obtida na primeira para obter a URL de download do relatório.

A chamada inicial é como segue, nela devem ser informados o ID do Pipe onde o relatório está salvo e o ID do relatório já formatado com todas as colunas e filtros que deseja visualizar na planilha extraída. Ambos os IDs podem ser obtidos na URL da página.

| mutation { exportPipeReport(input: { pipeId: 1, pipeReportId: 1}) { pipeReportExport { id } } } |

A resposta desta chamada conterá um ID numérico. Utilizando desse ID obtido na chamada anterior, você poderá rodar a seguinte query:

| { pipeReportExport(id: 20) { fileURL state startedAt requestedBy { id } } } |

A resposta da chamada conterá a URL (fileURL) que você pode acessar para fazer o download do relatório, na sua plataforma de integração.

É importante ressaltar que a construção do relatório para exportação pode demorar um pouco dependendo do volume de informações. Fique atento e, se necessário, deixe um período de tempo para o download. No momento que o relatório estiver formatado para a exportação a informação “state” deve retornar como “done”.

Tudo feito, basta fazer a carga em sua ferramenta de BI ou enviar para algum email como anexo!

Atualização!

Rate Limits

Essa feature possui Rate Limits, uma técnica comum para garantir segurança, confiabilidade e uma experiência consistente ao desenvolvedor, limitando o número de solicitações em um intervalo de tempo.

Para exportação de relatórios via API, o rate limit é de 25 solicitações em 24 horas, para cada pipe.

Caso atinga esse limite, deve-se aguardar 24 horas a partir do momento em que a última solicitação foi feita. Qualquer solicitação nesse intervalo de tempo não será processada e conterá uma mensagem de rate limit atingido exibida em "erros" no payload de resposta.